Способен ли искусственный интеллект решать за человека

В январе Совет Федерации поручил нескольким министерствам, включая минцифры и минэкономразвития, разработать дорожную карту по развитию технологий искусственного интеллекта (ИИ). Помимо прочего, она должна защитить людей от дискриминации со стороны автоматизированных систем. Plus-one.ru узнал, какие риски могут быть связаны с внедрением ИИ и что нужно делать, чтобы их избежать.

Стоит ли опасаться дискриминации

План по развитию ИИ должны утвердить до конца 2022 года. В Совфеде не пояснили, что подразумевается под дискриминацией. Но, как сообщает «Коммерсантъ» со ссылкой на анонимный источник, речь идет о неравном отношении к людям разных полов, возрастов, взглядов.

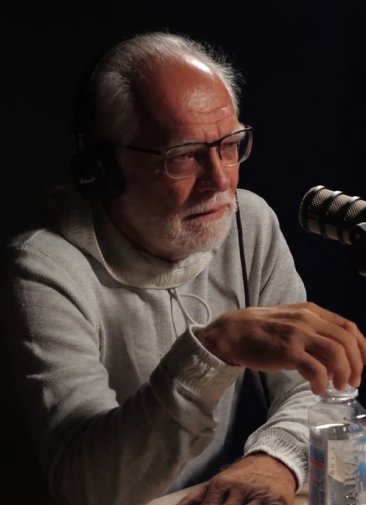

«Ситуации, когда применение ИИ приводит к дискриминации людей, вполне реалистичны, — сказал Plus-one.ru Александр Бухановский, научный руководитель исследовательского центра на базе Университета ИТМО „Сильный искусственный интеллект в промышленности“. — Но это не проявление его злонамеренности, а, можно сказать, издержки обучения». Эксперт пояснил, что для обучения алгоритмов используются заранее подготовленные наборы данных и в заложенных в них ситуациях ИИ работает хорошо. В остальных случаях он, как человек в незнакомой обстановке, принимает решения интуитивно и может ошибиться.

«Основной вопрос — это релевантность наборов данных для обучения, их соответствие тем условиям, в которых предполагается использовать систему, — комментирует Александр Бухановский. — Например, если ИИ рекомендует музыкальный контент, предварительно обучившись на предпочтениях девочек-тинейджеров, он навряд ли порадует пользователей-мужчин зрелого возраста. А поскольку провайдеры сервисов ИИ обычно сохраняют в секрете особенности обучения, у некоторых конечных пользователей может создаться впечатление, что их умышленно дискриминируют».

Специалист добавил, что продвинутые системы могут быть адаптивными и самообучаться на ошибках и обратной связи от пользователей. Таким образом, они накапливают собственный «жизненный опыт», становятся более «лояльными» и «толерантными». Но этот процесс бывает длительным, и пользователи могут разочароваться гораздо раньше, чем ИИ «поумнеет».

Такого же мнения придерживается директор Института искусственного интеллекта Университета Иннополис Рамиль Кулеев. По его словам, алгоритмы, которые сначала обучались на однородных данных определенной группы людей, а затем стали работать с другими людьми, могут принимать дискриминирующие решения. «Чтобы этого не происходило, необходимо разрабатывать подходы для создания датасетов, содержащих максимально разнообразные данные», — сказал Plus-one.ru эксперт.

Могут ли алгоритмы решать за человека

В Ассоциации больших данных (АБД) сообщили Plus-one.ru, что сегодня ИИ не способен принимать решения за человека, тем более в критических ситуациях. «Использование рекомендаций ИИ-систем с принятием окончательного решения человеком — единственный возможный сценарий на нынешнем уровне развития технологий», — говорит Рамиль Кулеев.

С ним соглашается Александр Бухановский. Он подчеркивает, что полностью автономный ИИ (может сам принимать и воплощать решения) обычно применяется для реализации простых когнитивных функций — например, для распознавания лиц и других объектов на видео, управления беспилотным транспортом. Цена ошибки может быть высокой. Но наличие больших наборов данных, описывающих все возможные условия, позволяет ее снизить, утверждает специалист. В других ситуациях, например при выполнении творческих заданий, ИИ может лишь предлагать варианты решений, ранжировать их по разным критериям и сопровождать их объяснениями. «Однако выбор конкретного решения остается за человеком», — подчеркивает Александр Бухановский.

Кто и как должен контролировать ИИ

Рамиль Кулеев считает, что в стране необходимо создать союз профессиональных участников рынка в области ИИ. Это, по его мнению, должна быть саморегулируемая организация, которая будет координировать деятельность членов, защищать их интересы и определять правила работы, в том числе этические аспекты.

В АБД тоже говорят, что дополнительного регулирования со стороны государства в индустрии ИИ не требуется: в России уже существуют Кодекс этики использования данных и Кодекс этики в сфере искусственного интеллекта. «Сейчас скорее оптимальное время для разработки технических стандартов», — говорят специалисты.

Напомним, Кодекс этики в сфере ИИ разработали в Альянсе в сфере искусственного интеллекта, его подписало несколько крупных технологических компаний и научно-исследовательских организаций, включая «Яндекс», «Сбер», «Газпром нефть», фонд «Сколково», Университет Иннополис, Университет ИТМО, НИУ ВШЭ.

Одна из целей создания кодекса — повысить лояльность к ИИ со стороны пользователей, общества и государства. Из результатов опроса ВЦИОМ и АНО «Национальные приоритеты» следует, что технологиям ИИ доверяют 48% россиян, 42% — не доверяют. 10% затруднились высказать свое мнение на этот счет.

В таких странах, как США, Канада, Германия, Великобритания и Австралия, к подобным технологиям с доверием относятся в среднем 28% жителей. При этом отношение связано со сферой применения ИИ. Люди чаще одобряют его использование в здравоохранении (например, для диагностирования заболеваний) и реже — в области управления персоналом (помощь в найме, принятие решения о повышении в должности). 67% участников опроса считают, что существующих норм и законов недостаточно для того, чтобы сделать применение ИИ безопасным.

Подписывайтесь на наш канал в Яндекс.Дзен.

Автор

Евгения Чернышёва